写在前面

当考虑在本地电脑上运行大语言模型(LLM)时,确保数据隐私和安全性显得尤为重要。有时候,出于安全和法律合规的考虑,我们不希望将敏感数据传输到互联网上使用大型在线模型。

为了解决这个问题,小七分享一种常见的做法是在本地环境中部署和运行模型。这种方法不仅提供了更高的数据控制权,还可以显著减少数据泄露的风险。

安装Ollama

下载Ollama:https://ollama.com/download

下载好之后安装提示一步一步安装即可,安装完成后会自动在后台运行,但是考虑到Ollama的默认模型下载地址是C盘,且无法通过界面更改,这里小七主要提供自定义模型下载的方法。

Ollama更改模型下载地址

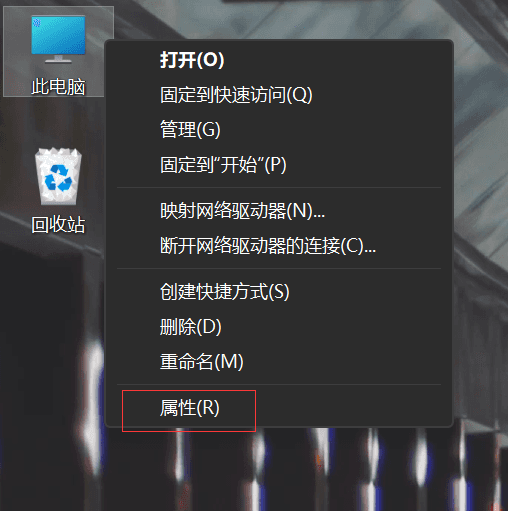

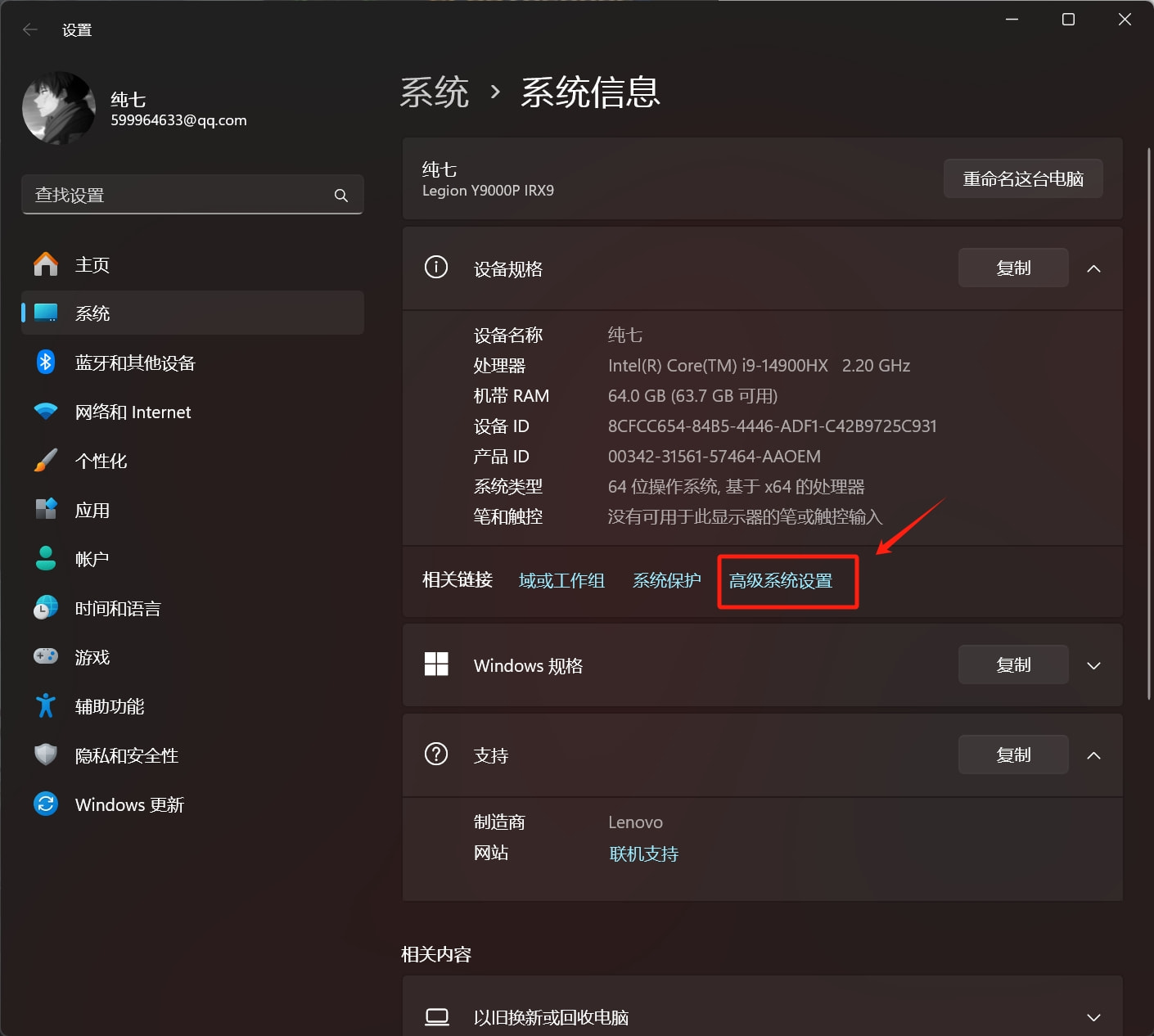

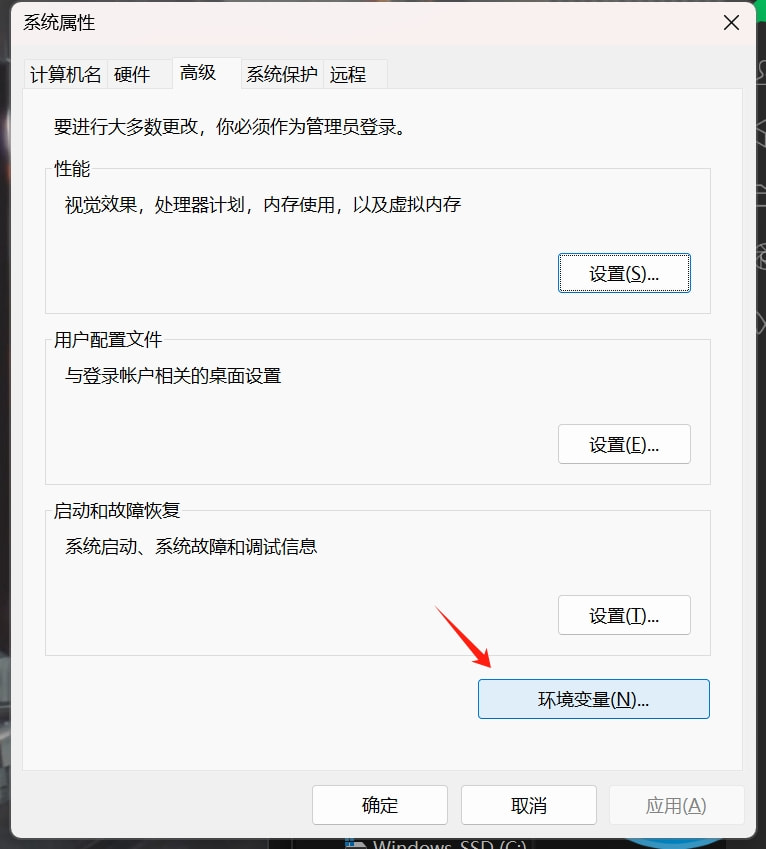

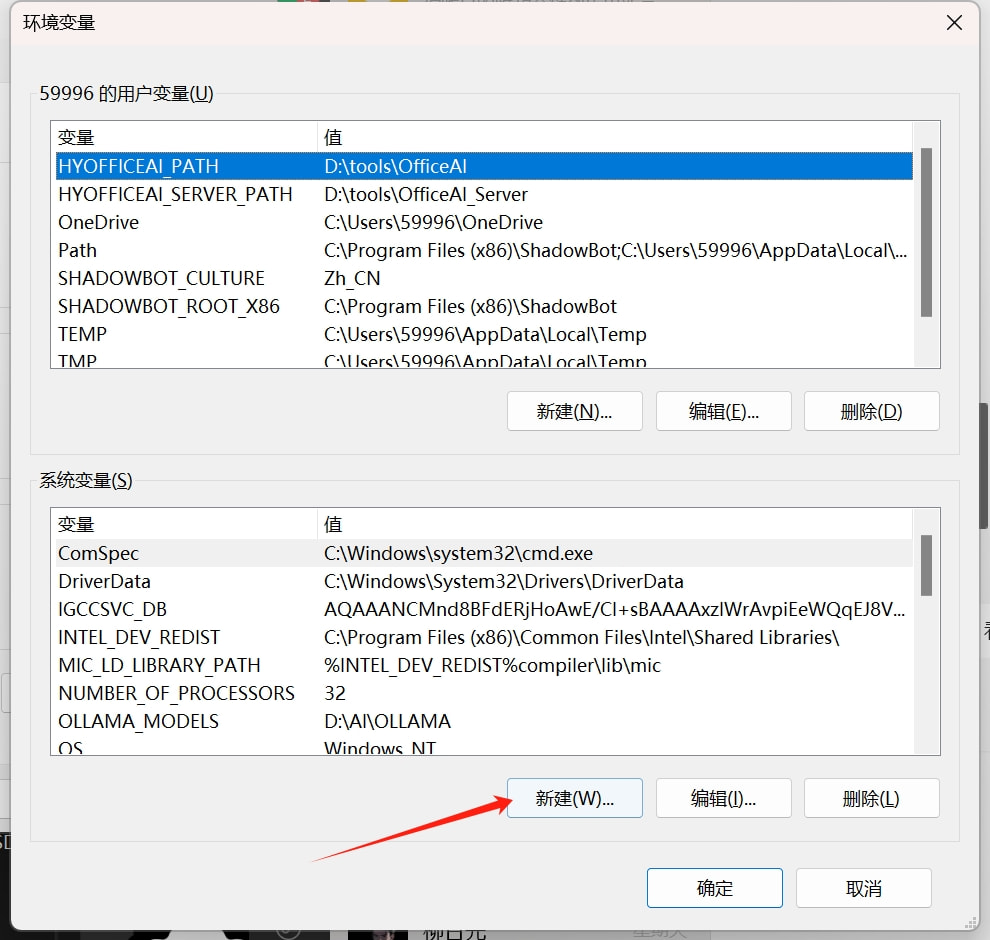

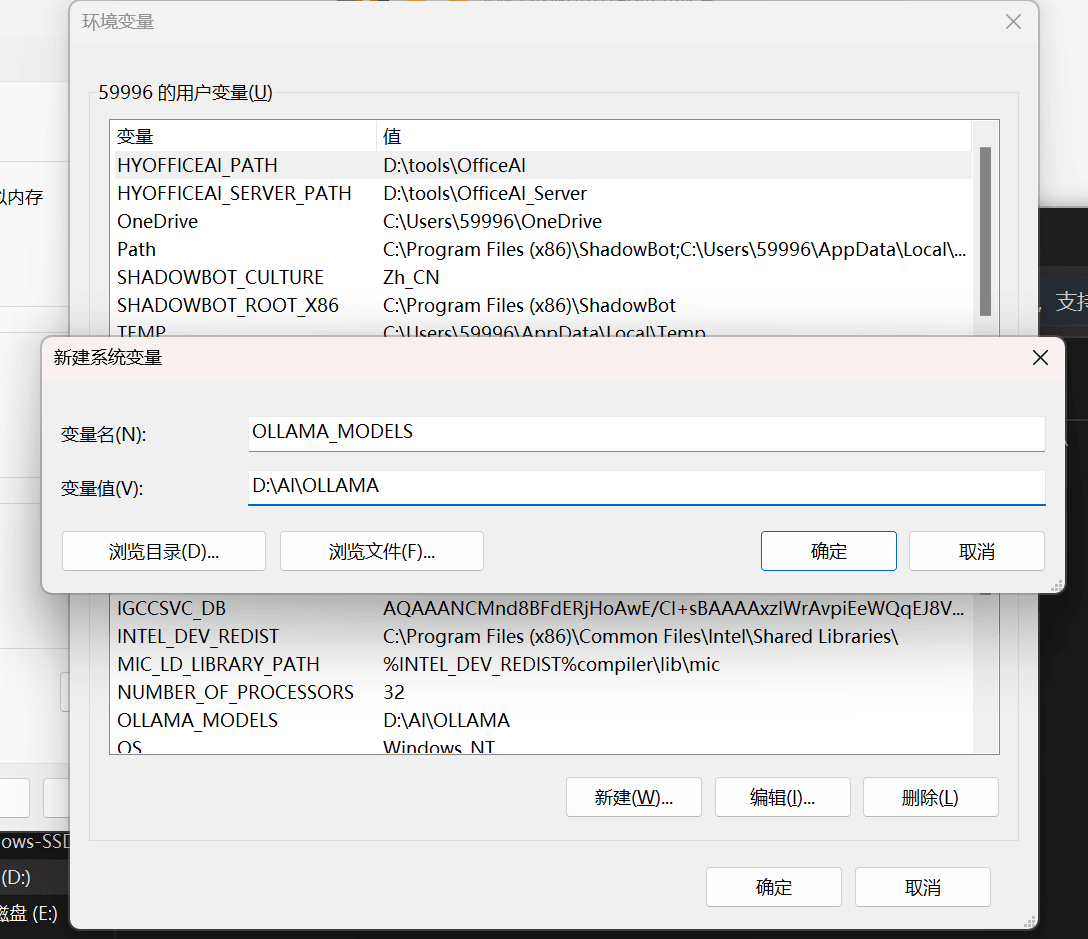

打开电脑属性 > 高级系统设置 > 环境变量

添加变量名:

OLLAMA_MODELS变量值就是需要自定义安装的位置,这里各位根据自身需求填写,只要不是C盘就好。

保存以后,我们准备开始下载模型

模型下载

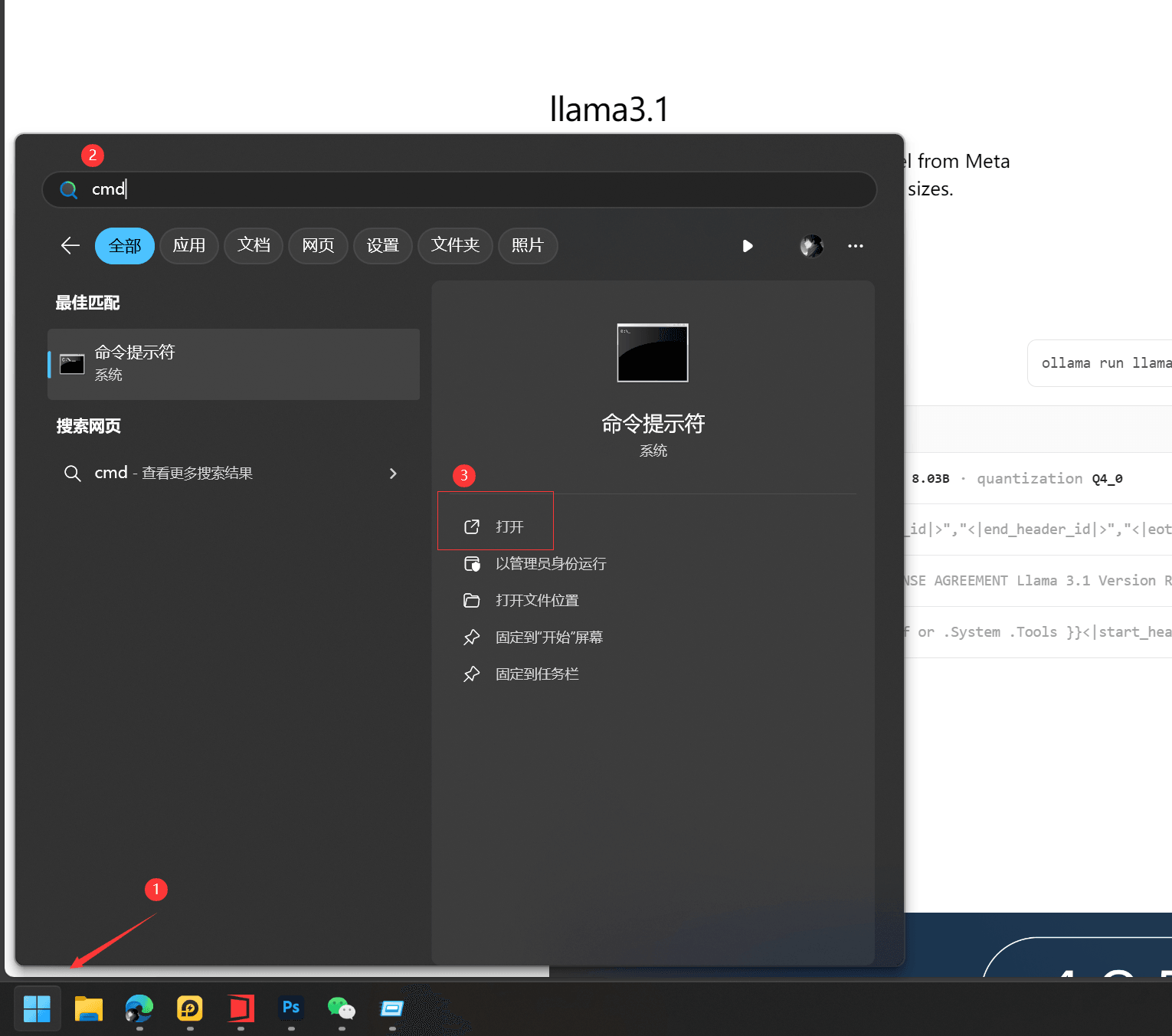

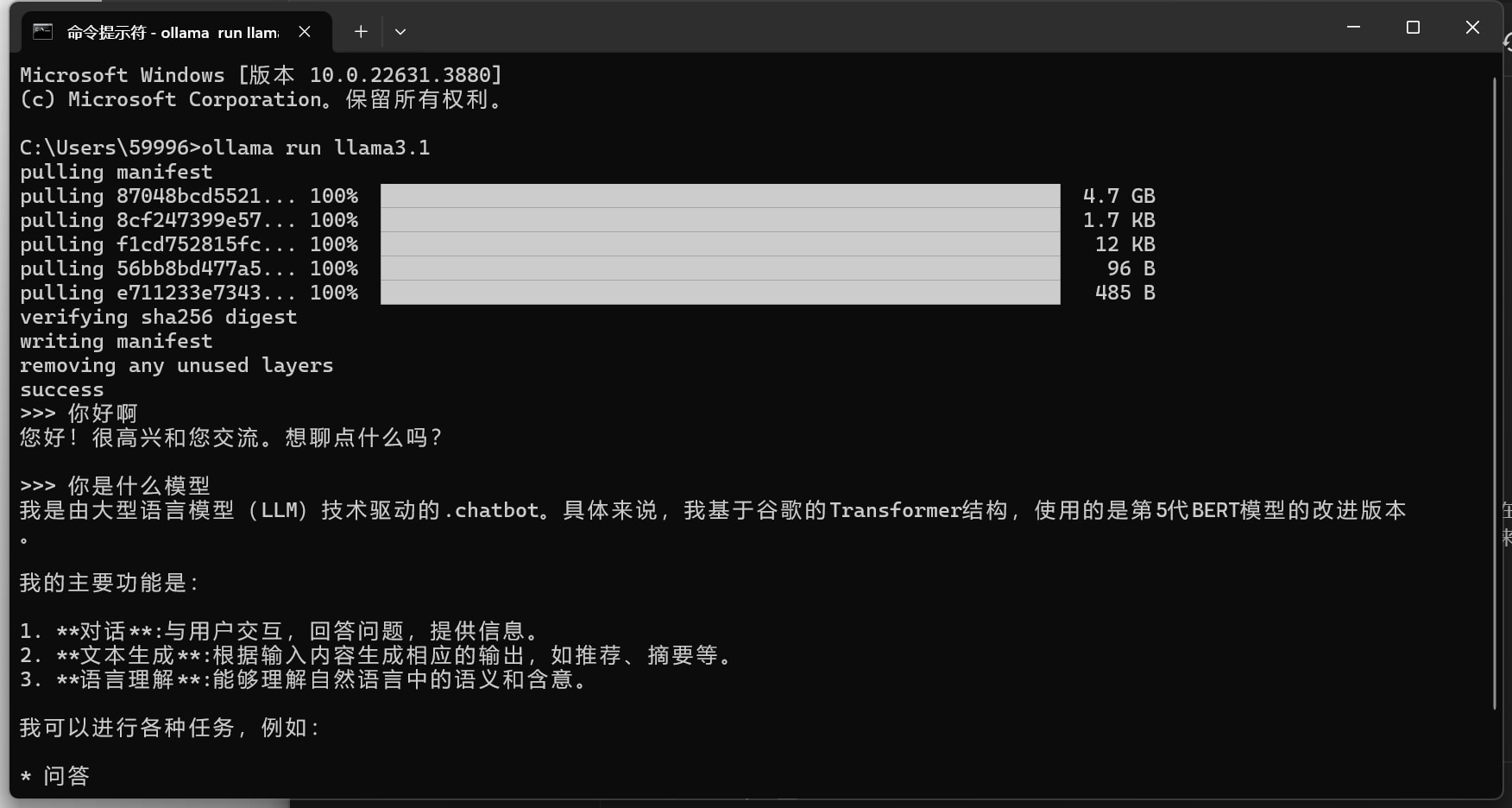

首先打开命令行工具 快捷键 win+R

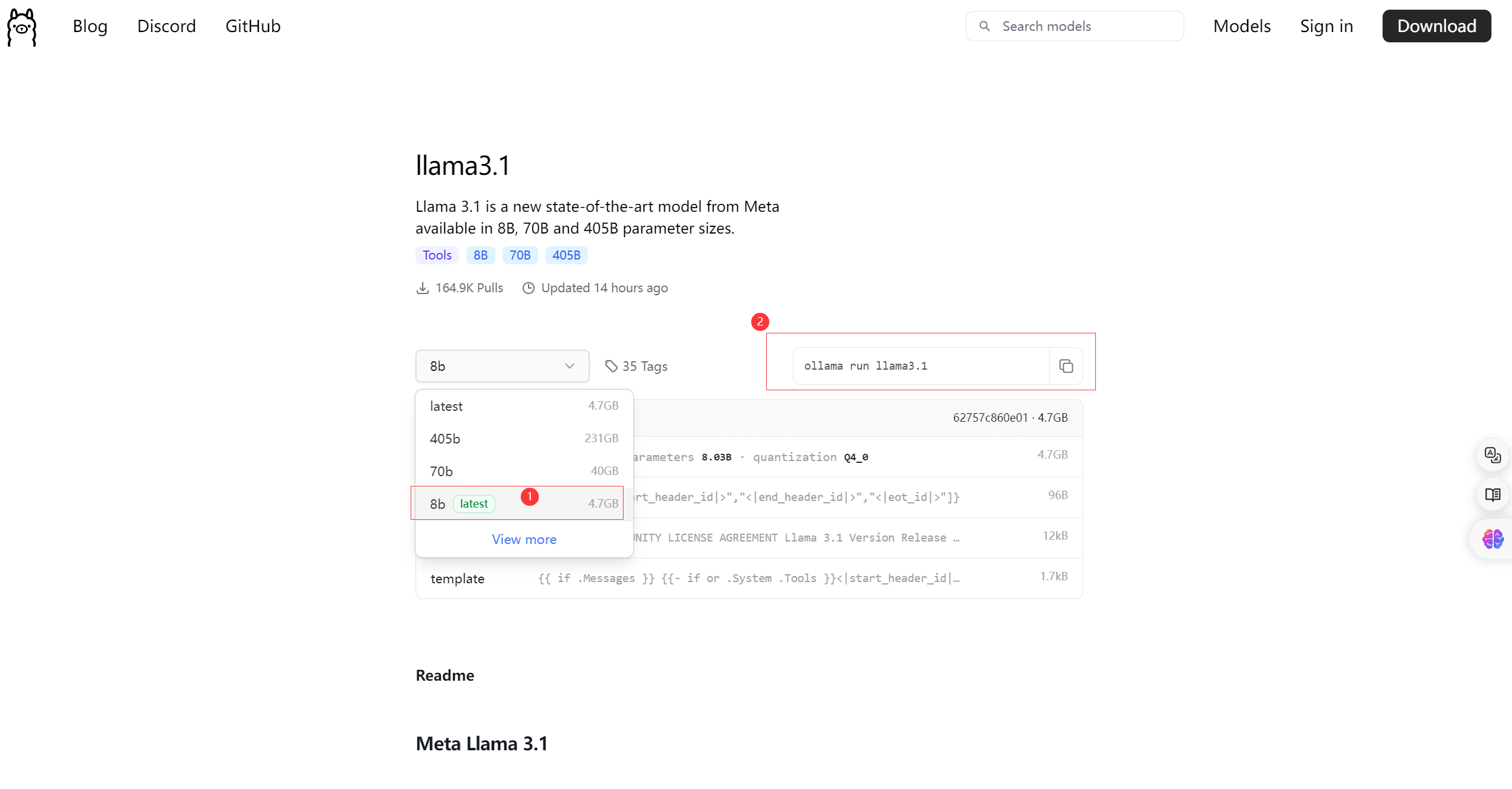

然后打开模型下载页面:https://ollama.com/library

这里以最新模型 llama3.1为例,模型下载默认选择8b就行,更高系统带不动。

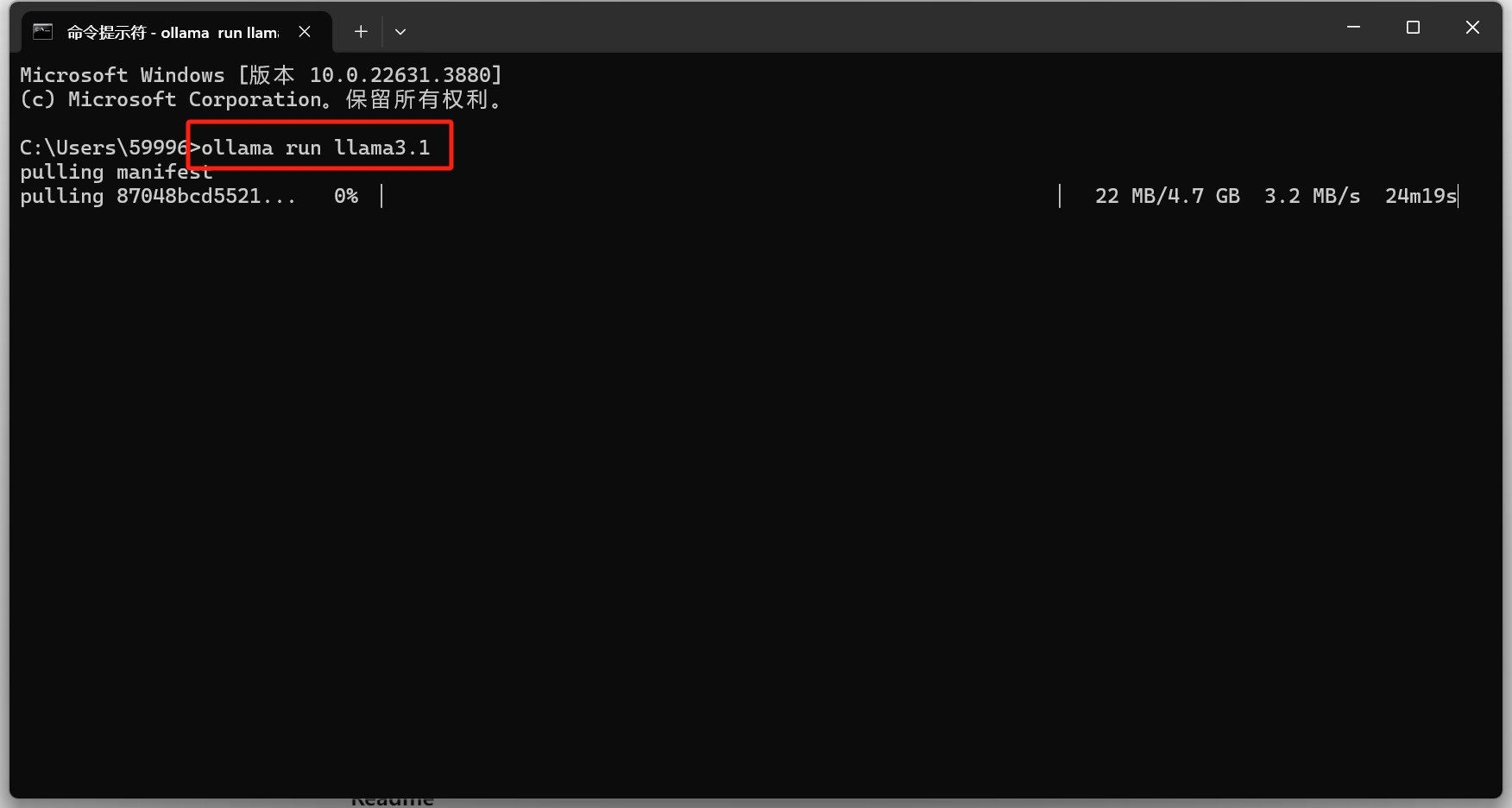

这里把复制 ② 的内容粘贴至命令行开始下载

这样我们就完成了ollama的安装,但是这样使用每次都要打开命令行,非常的麻烦,为简化后续使用流程和规范,我们进行下一步的chatbox的安装。

Chatbox安装

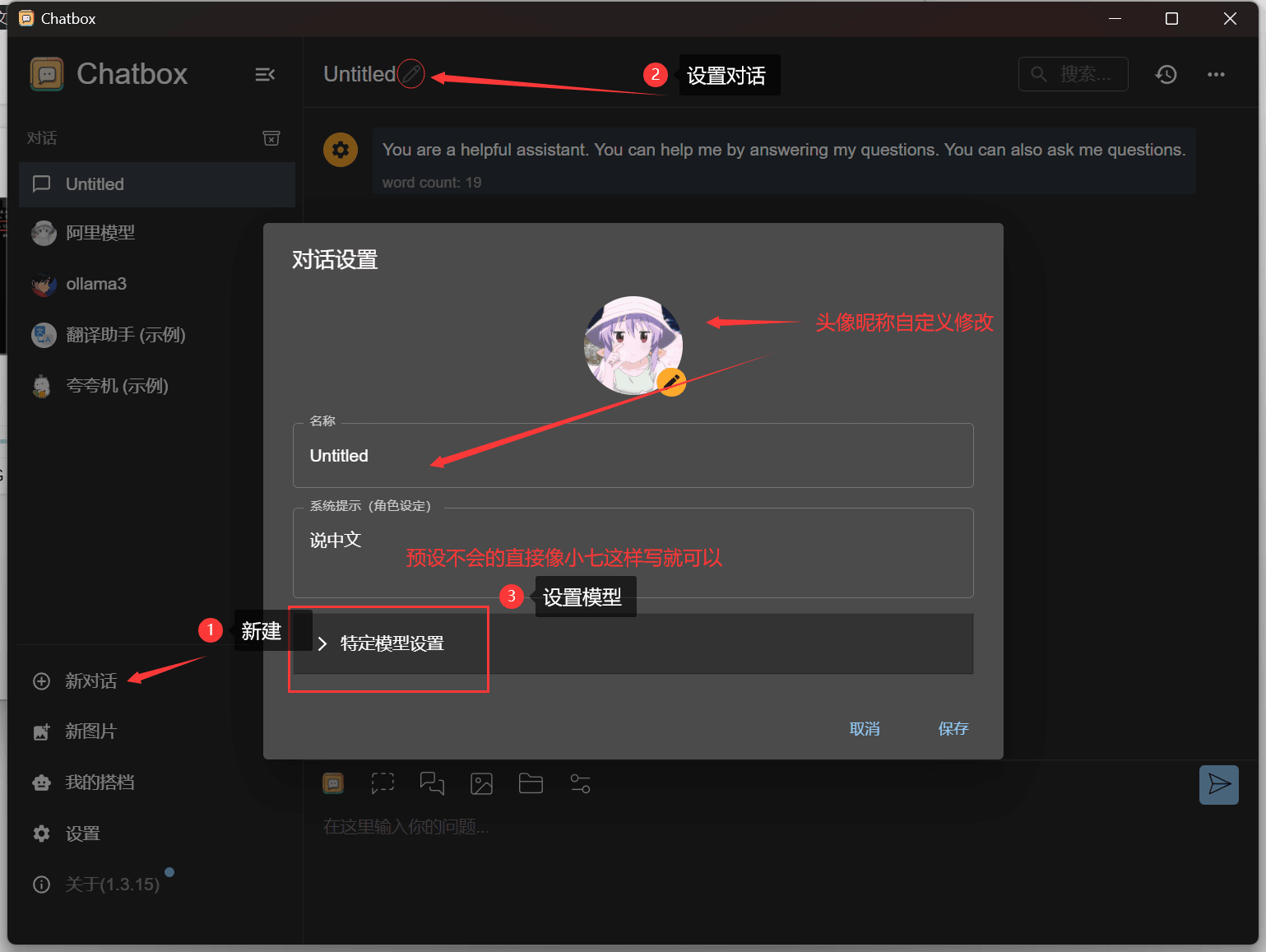

下载后直接按照即可,安装过程中不想安装到C盘就在安装程序中自定义更改位置。然后我们开始设置对话,如图所示:

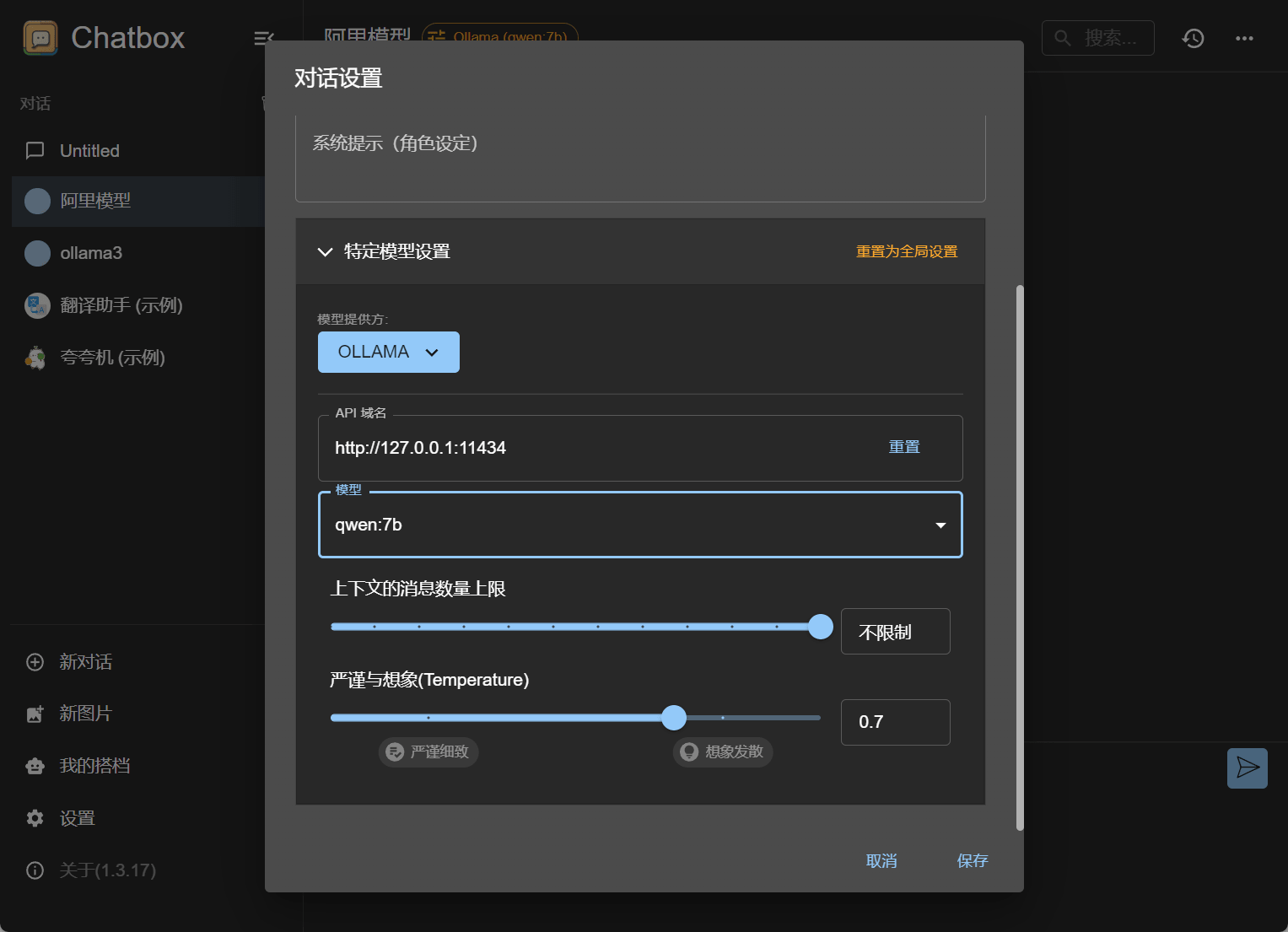

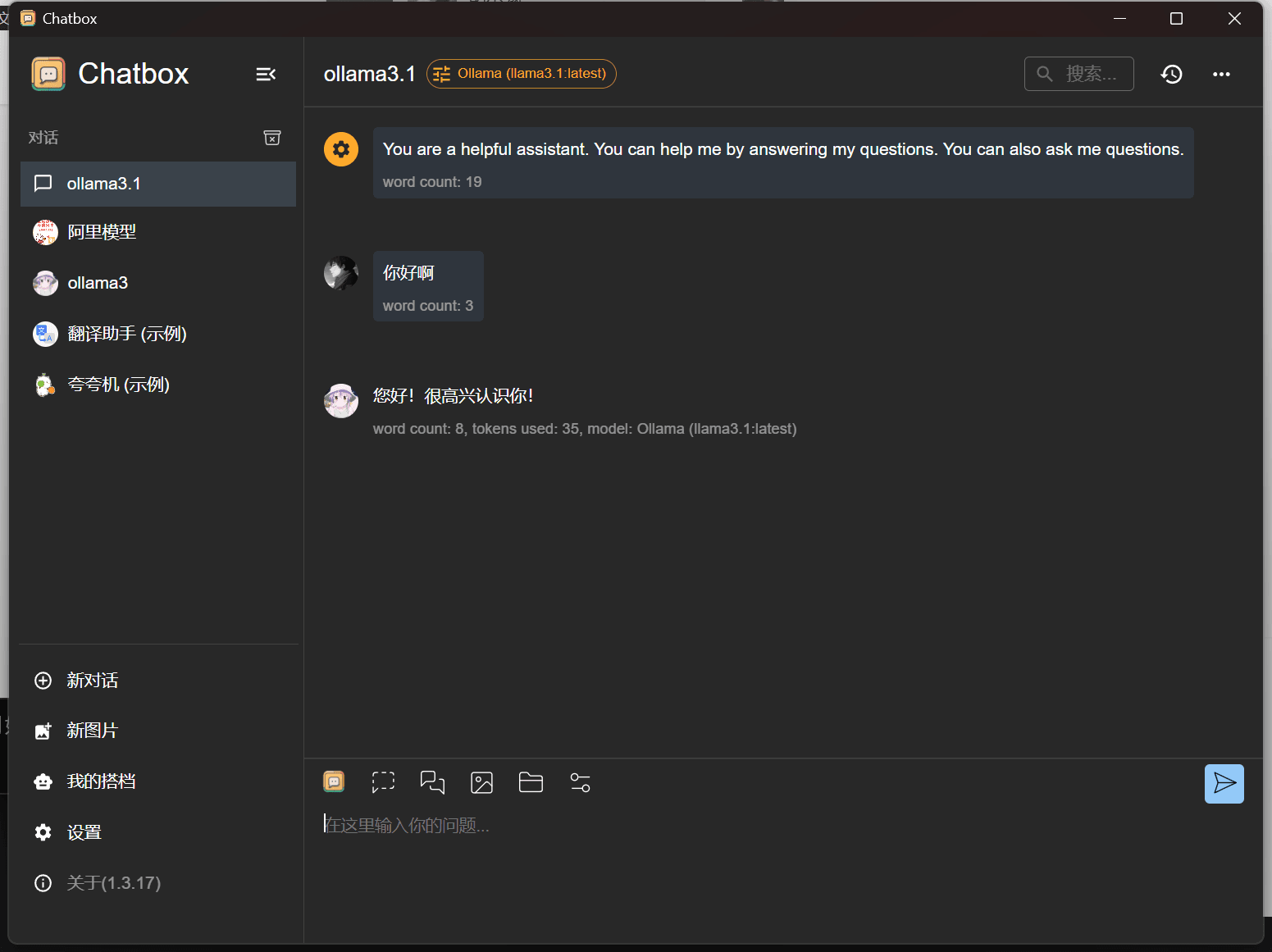

特定模型设置这里我们选择ollama,注意模型这里如果有你在本地下载了多个ollama模型,就新建一个对话,重新设置不同模型即可。

写在最后

ollama提供的大语言模型还有很多,具体的使用小七这里不多演示,毕竟ai的乐趣是需要触发才可以解锁的。